Artikel

by Ken Tilk, Head of Data&AI; Hannes Rõõs, AI Architect; Ulan Yisaev, AI Architect

Smart und immer auf dem neuesten Stand – ‚Intelligent Search‘ erleichtert das Leben

Mit ‚Intelligent Search‘ können Sie Fragen genauso wie in einem Gespräch stellen und ebenso mühelos Antworten erhalten. Tauchen Sie tief in die weite Welt Ihrer eigenen Daten ein. Sie können die Sprache verwenden, mit der Ihnen der Umgang am leichtesten fällt. Gleichzeitig haben Sie die Sicherheit, die durch den Einsatz großer Sprachmodelle (LLMs) und modernster Technologien gewährleistet wird.

Sich durch das heutige Informationslabyrinth zu navigieren, kann entmutigend sein. Oftmals bedeutet das, zwischen Dokumenten hin und her zu springen, Arbeitskollegen*innen zu befragen oder an unbekannte Türen zu klopfen – ‚Intelligent Search‘ macht Schluss mit diesen Unannehmlichkeiten. Alle Probleme werden in einer Lösung zusammengeführt, bei der Betriebsumgebung, Text- und Audio-/Videoformate sowie Kontextsprache keine Rolle spielen.

Was kann ‚Intelligent Search‘?

Stellen Sie sich eine einzige digitale Plattform vor, die SharePoint-Dateien, Confluence-Seiten, Teams-Meeting-Aufzeichnungen, E-Mails und sogar Ihre Kapazitätsplanungstools mühelos miteinander verbindet. Stellen Sie sich nun vor, dass Sie dieser Plattform eine einfache Frage stellen, wie zum Beispiel: „Zeige mir abgeschlossene Projekte im Industriesektor Finnlands“ oder „Welche Java-Entwickelnden stehen von September bis Dezember zur Verfügung?“

Es ist mehr als Fragen stellen; es geht um tiefes Verständnis. Ihr Team kann Fragen stellen und Antworten in der bevorzugten Sprache erhalten, selbst wenn der Ursprungsinhalt in einer anderen Sprache verfasst wurde. Sie gehen gerne ins Detail? ‚Intelligent Search‘ kann die exakte Quelle anzeigen, aus der die Antwort stammt.

Möchten Sie eine Unterhaltung führen? Wechseln Sie in den Chat-Modus, steigen Sie noch tiefer in die Thematik ein, stellen Sie Fragen und entdecken Sie mehr. Sie benötigen nur Erkenntnisse aus bestimmten Dokumenten? Testen Sie die Funktion „Dokument-Chat“ und seien Sie beruhigt, dass vom Kern-Datensatz kein Plagiat erstellt wird.

Das Beste daran? Wir formen ‚Intelligent Search‘ nach Ihren Wünschen und Vorstellungen – sei es auf einer Website, in Microsoft Teams oder auf einer Plattform Ihrer Wahl.

Wie funktioniert es?

‚Intelligent Search‘ nutzt modernste Technologien. Der Kern besteht aus der Retrieval Augmented Generation (RAG) für das Modul Frage-Antwort (QA). Dieser Ansatz ist eine Kombination aus abrufbasierten und generativen Methoden für QA und gewährleistet präzise und kontextuell relevante Antworten. Die RAG-Methoden garantieren dem Sprachmodell einen Zugang zu einer ständig aktualisierten Wissensbasis. Dieser Ansatz gilt im Allgemeinen als effizienter in Bezug auf Rechenressourcen und Zeit. Im Vergleich zum Trainieren eines Modells, sei es von der Basis an oder nur für Feinabstimmungen, wird auf diese Weise deutlich weniger Zeit benötigt. Je nach den spezifischen Anforderungen eines bestimmten Projekts besitzen wir trotzdem die Möglichkeit, ein Modell von Grund auf neu aufzubauen oder die Feinabstimmung durchzuführen.

Unsere Demo-Umgebung basiert auf dem Haystack Open-Source LLM-Orchestrierungs-Framework. Das ist jedoch nur eine der vielen Optionen in unserer hochgradig anpassbaren Lösung. Dank der Flexibilität von Haystack können wir die neuesten Modelle für die natürliche Sprachverarbeitung (NLP) integrieren, insbesondere die auf Transformer basierenden Modelle, die das Feld der semantischen Dokumentsuche, QA und Zusammenfassung revolutioniert haben. Dieses Framework eignet sich besonders gut für die Implementierung von Large-scale Fact-checking QA (LFQA)-Systemen. Dieses System verwendet einen großen Dokumentenkorpus als Wissensbasis. In dem zweistufigen Prozess der Abrufphase werden relevante Dokumente oder Passagen identifiziert und es erfolgt die Generierung. Bei der Generierung wird eine Antwort basierend auf den abgerufenen Dokumenten erstellt.

Die Flexibilität unserer Lösung ermöglicht es, sie an andere aktuelle Open-Source-Modelle anzupassen und sie entweder vor Ort oder bei einem beliebigen Cloud-Anbieter, einschließlich lokalen Anbietern, bereitzustellen. Anstatt direkt OpenAI-Modelle zu verwenden, integriert unser System die Azure OpenAI Service LLM-Modelle, damit wir Zugang zu den fortschrittlichsten Sprachmodellen besitzen und gleichzeitig von der Sicherheit und den Enterprise-Funktionen von Azure profitieren können.

Der Weg der Daten: Von der Erfassung bis zu indizierten Verknüpfungen

Die Grafik zeigt, wie Rohdaten in ein strukturiertes und durchsuchbares Format umgewandelt werden, wobei die Schritte zur Vorbereitung der Daten für eine effiziente Abrufbarkeit hervorgehoben sind.

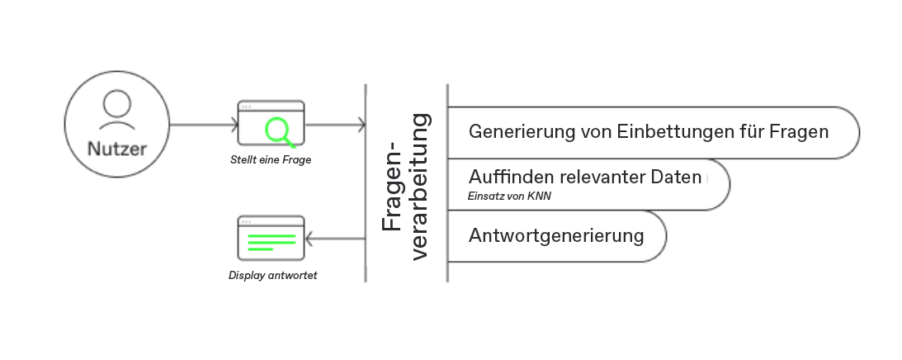

Benutzeranfragen entschlüsseln: Von einfachen Fragen zu intelligenten Antworten

Die Grafik unten zeigt den Prozess des Verstehens und Beantwortens von Benutzeranfragen, wobei die einzigartige Intelligenz bei der Generierung relevanter Antworten hervorgehoben wird.

Sicherheit, auf die Sie sich verlassen können

Im Zeitalter der Digitalisierung hat Sicherheit höchste Priorität, daher bietet Intelligent Search mehrere stabile Sicherheitsmaßnahmen.

Intelligent Search kann so angepasst werden, dass eine fein abgestufte Zugriffskontrolle verwendet wird, so dass nur Benutzende mit der Berechtigung zum Anzeigen der zugrunde liegenden Dokumente die Suchergebnisse sehen können. Dies ist vor allem dann von Vorteil, wenn Ihre Organisation sensible Daten verarbeitet oder Informationen strikt voneinander getrennt werden müssen.

Alle Daten werden unter Verwendung modernster Verschlüsselungsstandards kodiert – sowohl im Ruhezustand als auch während der Übertragung. Dies schützt nicht nur vor externen Bedrohungen, es gewährleistet auch, dass lesbare Daten im Falle eines Sicherheitsverstoßes nicht offengelegt werden.

Da unsere Demo-Umgebung den Azure OpenAI Service verwendet, profitiert sie von der robusten Infrastruktur von Microsoft Azure. Dazu zählt die Verschlüsselung von Daten im Ruhezustand sowie während der Übertragung mit einer FIPS-140-2-konformen 256-Bit-AES-Kodierung. Azure bietet zudem eine Missbrauchsüberwachung, um eine mögliche Bedrohung durch Cyberattacken frühestmöglich zu erkennen und diese zu verhindern.

Sie arbeiten bisher nicht mit Azure? Wenn Azure nicht Ihre bevorzugte Wahl ist, haben wir auch dafür eine Lösung. Intelligent Search kann so angepasst werden, dass die inhärenten Sicherheitsüberlegungen in Open-Source-Modellen und On-Premise-Hardware Priorität haben. Diese Flexibilität gewährleistet, dass unabhängig von Ihrer gewählten Implementierung die Datenintegrität und -sicherheit nicht beeinträchtigt werden.

Flexibel, vielseitig und modellunabhängig

Dabei entscheiden Sie, ob sie es entweder lokal oder bei Ihrem Cloud-Anbieter laufen lassen. In den letzten Monaten wurden mehrere leistungsstarke LLMs wie Falcon und Llama 2 von ihren Entwickelnden bereitgestellt. Dies eröffnet unzählige Möglichkeiten für Organisationen, die geschlossene oder kommerzielle Modelle von OpenAIs verwenden können oder wollen, da sie die Daten an ihre Server senden. Auch wenn die meisten Benchmarks GPT-4 noch immer höher einstufen als die besten Open-Source-Alternativen, schließt sich diese Lücke, und in vielen Anwendungsfällen ist sie unbedeutend.

Neben den generativen LLMs gibt es auch Modelle für viele andere verwandte Anwendungsfälle, wie zum Beispiel die semantische Suche. Die Leistung der besten Open-Source-Modelle für Textähnlichkeit ist vergleichbar mit dem Angebot von OpenAI, die Inferenzgeschwindigkeit ist hoch bei relativ geringen Hardware-Anforderungen. Das semantische Suchmodell kann nahtlos mit einem generativen LLM kombiniert werden, um die gesamte Intelligent Search-Pipeline abzudecken – dies ermöglicht detaillierte Antworten auf Fragen bezüglich Ihrer eigenen Dokumente. Indem die relevantesten Dokumente gefunden werden, generiert sich anschließend basierend darauf die Antwort. Es können ebenfalls LLMs verwendet werden, um Chatbots zu entwickeln. Diese berücksichtigen bei der Beantwortung von Nutzerfragen sogar frühere Diskussionen.

Obwohl es möglich ist, allgemein genutzte LLMs für die Übersetzung, Zusammenfassung und Beantwortung von Fragen zu verwenden, gibt es auch spezifische Open-Source-Modelle für andere Aufgaben verwandter Anwendungsfälle. Darüber hinaus gibt es auch Modelle, um bei Bedarf Sprache in Text und umgekehrt zu wandeln. Diese Vielfalt an Fähigkeiten ermöglicht es unserem Produkt, eine breite Palette von Aufgaben zu bewältigen und Vielseitigkeit sowie Nützlichkeit in verschiedenen Anwendungen zu gewährleisten.

Was benötige ich, um Intelligent Search zu hosten?

Die benötigte Hardware hängt davon ab, ob Sie das Modell selbst hosten oder lieber eine API eines Drittanbieters einsetzen möchten. Wenn Sie selbst hosten, müssen Sie entscheiden, ob dies auf einer Cloud- oder On-Premise-Plattform erfolgen soll. Wir haben praktische Erfahrung mit der Bereitstellung unseres Systems sowohl auf Azure- als auch auf AWS-Cloud-Plattformen sowie lokal. Jede Plattform bietet einzigartige Vorteile, von Skalierbarkeit und Leistung bis hin zu spezifischen Sicherheitsfunktionen und regionalen Datenspeicherungsoptionen.

Wenn Sie LLMs nicht als Service eines Drittanbieters wie OpenAI verwenden, sollten Sie beachten, dass LLMs im Allgemeinen auf sehr großen Datenbestände trainiert sind und über Milliarden trainierbare Parameter verfügen, was bedeutet, dass der Betrieb viel Rechenleistung erfordert. Für die Ausführung der meisten LLMs ist der Zugriff auf GPU- oder TPU-Leistung erforderlich, da die Ausführung auf CPUs in den meisten Fällen zu langsam sein wird.

Aufgrund der erheblichen Hardware-Anforderungen, die mit LLMs verbunden sind, haben wir uns bemüht, die Anforderungen zu verringern, ohne dabei die Leistung zu beeinträchtigen. Ein Ansatz besteht darin, quantisierte Versionen dieser Modelle zu verwenden. In diesem Kontext bezieht sich Quantisierung auf die Reduzierung der numerischen Genauigkeit, bei der Gleitkommawerte unter Verwendung eines kleineren Satzes von Bits approximiert werden. Obwohl diese Technik zu einer Verringerung der Rechenlast und des Speicherbedarfs von LLMs führen kann, geht sie stets mit Kompromissen in Bezug auf die Präzision einher. Der Quantisierungsprozess kann zu einem Verlust feiner Details in der Ausgabe des Modells führen und möglicherweise die Qualität und Genauigkeit des generierten Textes beeinträchtigen. Daher sollte die Entscheidung zur Bereitstellung quantisierter LLMs sorgfältig gegen die spezifischen Anforderungen des Anwendungsfalls in Bezug auf Präzision und Leistung abgewogen werden. Der Wechsel von 16-Bit-Genauigkeit auf 8-Bit-Genauigkeit führt nicht zu einem spürbaren Qualitätsverlust in der Ausgabe, während der Wechsel zu einer 4-Bit-Version einen stärkeren Einfluss hat.

Obwohl einige kleinere LLMs für den persönlichen Gebrauch auf leistungsstärkeren Laptops evaluiert werden können, folgt die Bereitstellung von LLMs für den industriellen Einsatz im Wesentlichen zwei Hauptwegen: On-Premise-Bereitstellung oder Cloud-basierte Lösungen. Die On-Premise-Implementierung umfasst die Konfiguration und Bereitstellung der Modelle in der eigenen Infrastruktur Ihrer Organisation. Dieser Ansatz gibt Ihnen mehr Kontrolle über die Datensicherheit, Datenschutz und Compliance und ermöglicht gleichzeitig eine Anpassung gemäß Ihren geschäftlichen Anforderungen. Alternativ beinhalten Cloud-Lösungen die Nutzung der Rechenressourcen und Infrastruktur von Cloud-Anbietern. Die Cloud-basierte Bereitstellung bietet Skalierbarkeit und Flexibilität und ermöglicht es Ihnen, sich schnell an unterschiedliche Arbeitslasten anzupassen, ohne stark in Hardware investieren zu müssen. Sie entlastet auch von der Verwaltung und Wartung der Hardware, sodass Ihre Teams sich auf ihre Kernaufgaben konzentrieren können. Die Wahl zwischen On-Premise- und Cloud-Bereitstellung hängt von Faktoren wie Sicherheitsanforderungen, betrieblichen Präferenzen und der verfügbaren technologischen Infrastruktur ab.

Wo kann ich Intelligent Search ausprobieren?

Vereinbaren Sie gerne einen Demo-Termin. Wir werden Sie durch die Anwendung führen, welche wir bei Bedarf mit Ihren eigenen Beispieldaten für Sie vorbereiten.

Kontaktieren Sie uns

Wir machen Ihr Projekt zu unserem Anliegen.